Kolejny rozdział w poradniku Google dotyczy metod radzenia sobie z robotami wyszukiwarek. Osobiście ten temat wolę nazywać komunikacją z robotem, bo tak naprawdę nie chodzi o to, żeby sobie z nim poradzić, ale udostępnić mu maksymalnie dużo informacji na temat naszego serwisu.

Uwaga! Dokument Najlepszych praktyk SEO od Google znajduje się pod adresem http://www.google.com/webmasters/docs/search-engine-optimization-starter-guide.pdf (w języku angielskim).

Temat poruszany w tym rozdziale mógłby znacznie szerszy, ale Google ograniczyło się tylko do dwóch zagadnień (we wcześniejszych rozdziałach było kilka odniesień do tego tematu, ale w innym kontekście). Skoro tak postanowiło to również ja ograniczę się tylko do odniesienia do tego co Google wskazało za istotne szczególnie, że też wcześniej nawiązywałem do tych tematów w poprzednich wpisach.

Osobiście brakuje mi w tym rozdziale poradnika szerszego skupienia się na temacie adresów kanonicznych, plików map witryny, przekierowań, migracji serwisów ze starej struktury. Ale może to zbyt szeroki i skomplikowany temat na dokument będący poradnikiem na start. Może kiedyś Google wyda dokument dużo bardziej zaawansowany. Czekam!

Efektywne wykorzystanie pliku robots.txt

Lokalizacja pliku robots.txt

Plik robots.txt służy przede wszystkim do przedstawienia robotom informacji, które zasoby powinny być indeksowane, a które nie. Plik ten powinien być tworzony dla każdego serwisu – nawet jeżeli wszystko ma być indeksowane – i umieszczany w głównym katalogu serwisu. Plik tego blogu pozwalający na wszystko znajduje się pod adresem:

http://www.trajdos.pl/robots.txt

Generator pliku robots.txt

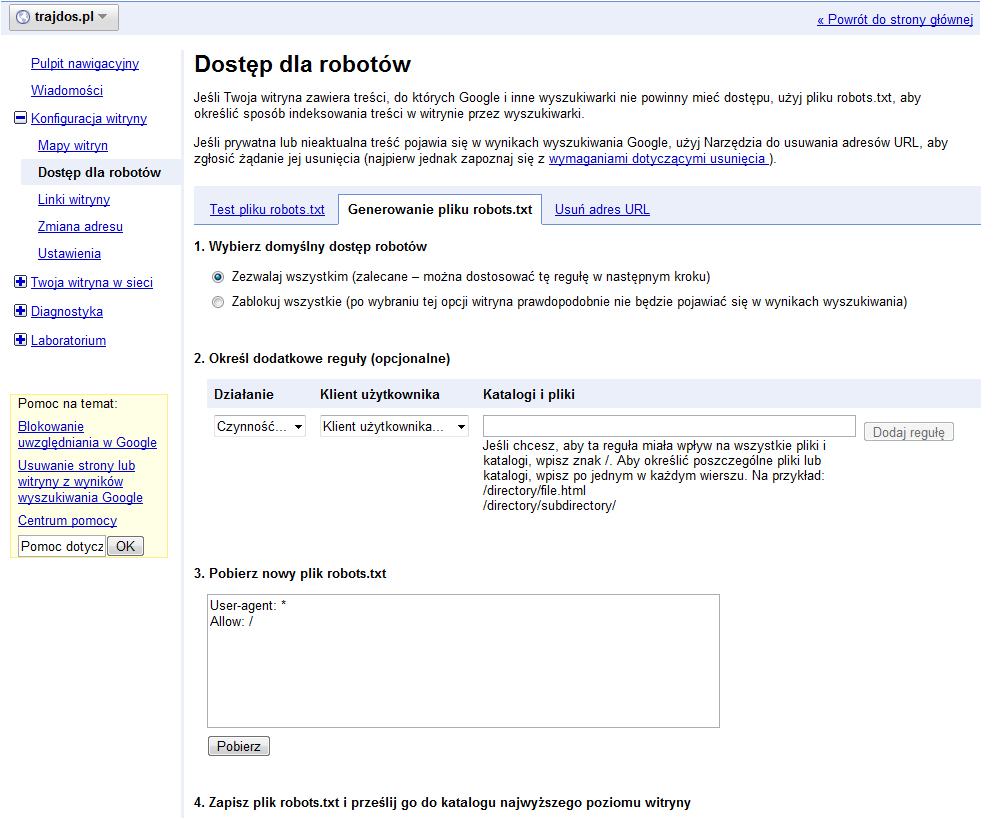

Google w narzędziach dla webmasterów udostępnia bardzo prosty generator pliku robots.txt, który pozwala na dodawanie reguł zezwalających i blokujących dostęp do zasobów serwisu.

Umieszczając plik robots.txt należy pamiętać, że reguły blokujące tam zawarte nie blokują dostępu do wskazywanych zasobów, a jedynie informują, że właściciel serwisu nie chce umieszczać określonych zasobów w indeksie wyszukiwarki.

Blokowanie dostępu do treści

Jeżeli jakiś zasób ma być niedostępny dotarcie do niego powinno wymagać loginu i hasła konta, które ma uprawienia pozwalające na korzystanie z niego. W przypadku serwera Apache można skorzystać z pliku .htaccess, który pozwala założyć dla dowolnego folderu login i hasło. Metod chronienia danych jest bardzo wiele i nie są one tematem tego wpisu.

Świadome wykorzystanie atrybutu rel=”nofollow” linków

Atrybut rel z wartością nofollow aktualnie wykorzystywany powinien być tylko do walki ze spamem. Szczególnie z automatami (również z ludzmi, którzy dodają umyślnie wpisy z linkami), które w nieograniczony sposób próbują dodawać komentarze do różnego rodzaju stron. Oczywiście komentarze zawierają linki, które mają służyć między innymi do pozycjonowania stron, ale też do ściągania frajerów, którzy na stronach docelowych znajdą niespodzianki w postaci wirusów i innych szkodników lub przekażą pieniądze dla wujka z Nigerii.

Przeznaczenie atrybutu rel=”nofollow”

Dodanie do linku atrybutu rel=”nofollow” informuje robota wyszukiwarki, że jest to link, który nie jest polecany, czyli nie chcemy żeby robot za nim podążał i nie chcemy mu przekazać autorytetu naszej strony. Oczywiście jest to tylko informacja dla robota. W przypadku Google autorytet nie powinien być przekazany, ale robot mimo wszystko może podążyć za linkiem i zbadać stronę docelową.

Miejsca gdzie warto korzystać z atrybutu rel=”nofollow”

Mechanizm automatycznego dodawania atrybutu rel=”nofollow” warto stosować wszędzie tam gdzie użytkownicy mogą dodawać treści. Do takich miejsc można zaliczyć komentarze, księgi gości, fora, tablice, listy polecanych linków itp.

Konwekwencje nie stosowania rel=”nofollow”

Zgodnie z polityką Google użytkownik nie może odpowiadać, za to z jakich stron prowadzą linki do jego serwisu, ale ma pełną kontrolę nad tym do kogo on linkuje. Dlatego umieszczanie linków do stron o wątpliwej jakości może się bardzo negatywnie przełożyć na autorytet strony, a to na jej widoczność w wynikach wyszukiwania.

W celu uniknięcia kary warto tam gdzie trudno weryfikować każdy link umieszczać standardowo atrybut rel=”nofollow”. Oczywiście moderacja linków też jest konieczna, ale dodanie informacji, że nie polecamy tego linku w większości wypadku jest wystarczające, ale ciągle trzeba pamiętać o doznaniach użytkownika, który dostaje link do podejrzanych stron.

Walka ze spamem poprzez Captcha i Akismet

Większość spamerskich linków dodawana jest na stronę przez automaty wykorzystujące dziury w mechanizmach pozwalających na tworzenie treści przez użytkowników. W celu zminimalizowania zagrożenia warto korzystać z mechanizmu Captcha, czyli generowania kodu jaki należy wpisać w odpowiednie pole w celu potwierdzenia swojej ludzkości. Kody te są tak tworzone, że większość robotów nie potrafi sobie z nimi poradzić.

Oczywiście każde zabezpieczenie zostanie kiedyś złamane, dlatego korzystając z WordPress warto dodatkowo korzystać z wtyczki Akismet (wyłapuje spamerskie komentarze po ich dodaniu) oraz poświęcać czas na moderację treści, które mimo poprzednich zabezpieczeń dostały się na stronę. W przypadku małego blogu jak ten warto włączyć mechanizm wymuszający akceptowanie każdego dodanego przez użytkownika komentarza przez moderatora lub administratora przed publikacją na stronie wpisu.

Podsumowanie

Rozdział poradnika mówiący o tym jak radzić sobie z robotami porusza wycinek tematu komunikacja z mechanizmami indeksującymi. W innych częsciach rad Google poruszane są równie lakonicznie tematy związane z mapami witryn, adresami kanonicznymi itp. Osiągnięcie maksymalnej skuteczności wymaga umiejętnego połączenia wszystkich elementów komunikacji z wyszukiwarką. Niestety jak to skutecznie robić Google nie napisało. A szkoda! Bo tak naprawdę świadome korzystanie przez użytkowników z tych mechanizmów ułatwiłoby wyszukiwarce dokładniejsze określanie tematyki serwisu, a tym samym mogłaby się poprawić jakoś prezentowanych wyników.